Una IA leyó lo que escribió otra y trató de adivinar su personalidad (y su tono)

Un experimento con datos sintéticos y multitask learning para ver si un modelo puede leer entre líneas y adivinar cómo suena un texto, y quién podría haberlo escrito.

A veces, los experimentos más interesantes empiezan con una pregunta rara. En este caso: ¿podría una inteligencia artificial leer un texto y decirnos no solo qué tono tiene, sino también qué tipo de personalidad podría haber detrás?

Y ya que estamos... ¿y si ese texto también lo hubiera escrito otra IA?

Eso fue exactamente lo que intenté: un experimento en el que le enseño a una IA a hacer dos cosas a la vez. Una es detectar el tono; la otra, reconocer rasgos de personalidad al estilo MBTI (Myers–Briggs Type Indicator).

Así que llevamos a otra IA al laboratorio y la pusimos a trabajar generando textos cuidadosamente diseñados para reflejar distintas combinaciones de personalidad y tono.

¿Puede esto enseñarnos algo sobre cómo la personalidad y el tono se filtran, incluso sin querer, en lo que escribimos?

Spoiler: sí.

Nuestro asistente de laboratorio

Antes de poder entrenar a nuestro otro asistente, necesitaba datos. Y como no hay un dataset que venga con mensajes ya etiquetados con tono y personalidad (y mucho menos generados por humanos con tipos MBTI), decidí hacer lo más sensato: crear mi propio dataset… con otra IA.

Usé un modelo de lenguaje (DeepSeek) para generar comunicados breves, en español, con dos ingredientes clave:

Un tono explícito (por ejemplo: formal, empático, entusiasta…).

Un perfil de personalidad implícita, basado en los cuatro ejes del MBTI:

Extroversión (E)

Intuición (N)

Pensamiento (T)

Percepción (P)

La idea era que el tono fuera obvio, pero la personalidad quedara escondida entre líneas. No le pedía al modelo que dijera “esta persona es INTP”, sino que escribiera como si tuviera ese estilo. El resultado debía sonar natural, profesional, y humano.

Para cubrir bien el espacio, generé combinaciones balanceadas entre tonos, países de Latinoamérica y rasgos de personalidad. Todo eso se convirtió en varios miles de ejemplos sintéticos listos para entrenar.

Nuestro asistente de laboratorio trabajó sin quejarse.

Instrucciones

SYSTEM_MESSAGE = {

"role": "system",

"content": (

"Eres un generador profesional de comunicados de prensa en español. "

"Tu tarea es redactar textos breves (3 a 5 frases) alineados con ciertos valores de personalidad y tono, "

"sin explicarlos, interpretarlos ni mencionarlos. "

"Nunca incluyas análisis, justificaciones, etiquetas ni reflexiones. "

"El texto debe parecer completamente natural, como si hubiese sido escrito por un humano profesional en relaciones públicas."

)

}USER_MESSAGE = f"""

Redacta un comunicado de prensa breve en español (3 a 5 frases) para el público de {country}, en el contexto de: {context}.

Este mensaje debe reflejar de manera implícita los siguientes parámetros internos de personalidad:

- Extroversión: {mbti['E']}

- Intuición: {mbti['N']}

- Pensamiento: {mbti['T']}

- Percepción: {mbti['P']}

Además, debe mantener un tono claramente **{tone.lower()}** desde el inicio hasta el final.

Importante:

- No expliques ni describas la personalidad o sus características.

- No menciones los valores anteriores ni hagas referencia a ellos.

- No incluyas análisis, etiquetas, ni justificaciones.

- Solo escribe el comunicado de prensa, de forma natural, coherente y sin salirse del tono.

Máximo: 250 palabras o 400 tokens.

"""Ejemplo de respuesta

Comunicado Oficial:

Nombramiento de Nuevo Director General [Empresa] anuncia el nombramiento del Sr. [Nombre del Nuevo CEO] como su nuevo Director General, efectivo a partir de [Fecha]. El Sr. [Nombre], con una sólida trayectoria en gestión operativa y desarrollo estratégico en el sector tecnológico, asume el liderazgo para guiar la siguiente etapa de la organización. Su enfoque se centrará en la adaptación continua a las dinámicas del mercado y en fortalecer las operaciones actuales para lograr los objetivos establecidos. La Junta Directiva expresa su confianza en su capacidad para dirigir la empresa hacia un futuro sostenible.Nuestro segundo asistente: el que aprendió dos cosas a la vez

Con todo listo, tocaba la parte más divertida … experimentar: enseñarle a un modelo a leer y adivinar cosas.

No cualquier cosa: dos tareas distintas al mismo tiempo.

Por eso usamos un enfoque de multitask learning: una sola IA que aprende a hacer más de una tarea con el mismo texto como entrada.

¿Qué tareas?

Predecir el tono del mensaje (Ejem: empático, formal, entusiasta, etc.)

Estimar los rasgos de personalidad (como valores numéricos entre 0 y 1 para extroversión, intuición, pensamiento y percepción)

¿Y quién fue el aprendiz?

Un modelo llamado BERT.

BERT (por Bidirectional Encoder Representations from Transformers) es un modelo de lenguaje diseñado para entender el contexto completo de un texto. A diferencia de otros modelos que leen solo hacia adelante (como si siguieran una oración palabra por palabra), BERT lee en ambas direcciones al mismo tiempo. Eso lo convierte en una especie de lector atento: no solo entiende lo que viene, sino también lo que vino antes. Y eso es ideal para tareas de comprensión.

En nuestro caso, aprovechamos esa capacidad para pedirle dos cosas a la vez: que clasifique el tono del mensaje y que prediga los rasgos de personalidad.

Ambas tareas se entrenan juntas, en paralelo, a partir del mismo texto. Eso no solo es más eficiente, sino que a veces ayuda a que una tarea refuerce a la otra (porque entender el tono puede darte pistas sobre la personalidad... y viceversa).

Resultados: ¿Qué tan bien lo hizo?

Una vez entrenado el modelo, venía la parte más esperada (y temida): ver si realmente había aprendido algo.

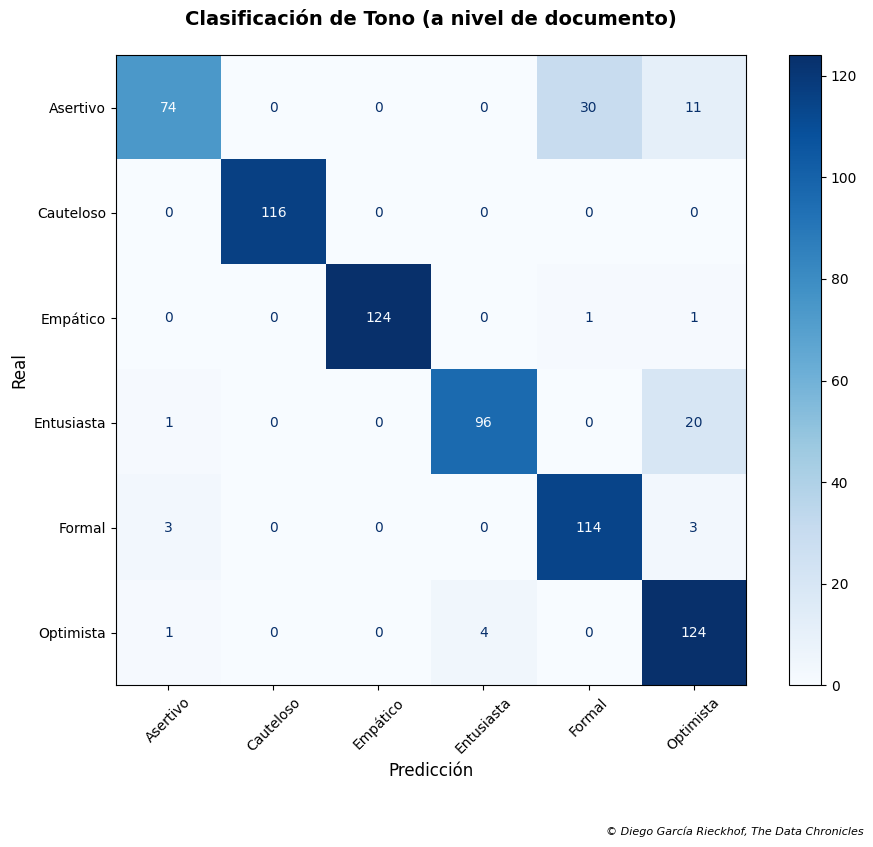

1. Detectar el tono le resultó bastante fácil

Las predicciones de tono fueron, en general, buenas. No perfectas, pero con buena precisión. Al parecer, el tono sí deja huellas claras en la forma en que está escrito un texto, incluso si fue generado artificialmente.

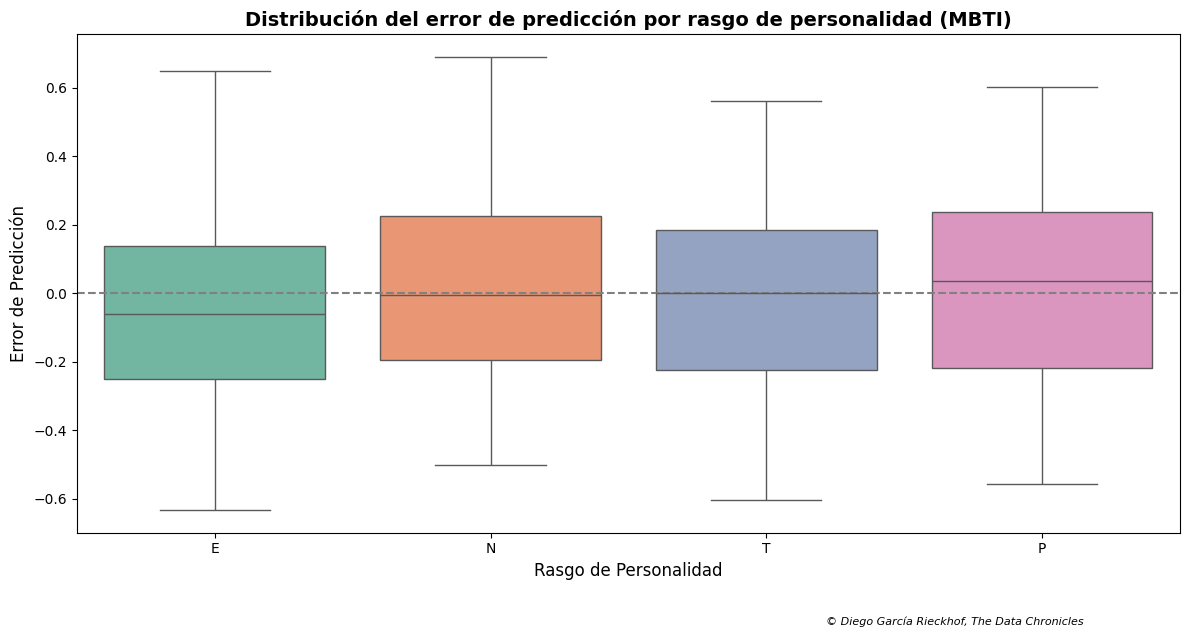

2. La personalidad fue otro tema

Cuando pasamos a los rasgos MBTI, la cosa se volvió más difusa. No es que el modelo no aprendiera nada, pero los resultados fueron más suaves: predicciones razonables, pero lejos de ser perfectas.

Tiene sentido: los rasgos de personalidad no eran explícitos, sino inferidos. Estaban ahí, pero escondidos entre múltiples oraciones.

Aun así, el modelo lograba captar ciertos patrones.

¿Es concluyente? No. ¿Es interesante? Sí.

Conclusiones

Este experimento prueba que incluso cuando los textos son generados por una IA, algo del tono y la personalidad se cuela en las palabras.

¿Detectarlo con otra IA? No es trivial, pero tampoco imposible.

Con un poco de imaginación, data, y algunas pruebas, podemos entrenar modelos que no solo lean texto, sino que intuyan cómo suena… y qué tipo de “voz” podría haber detrás.